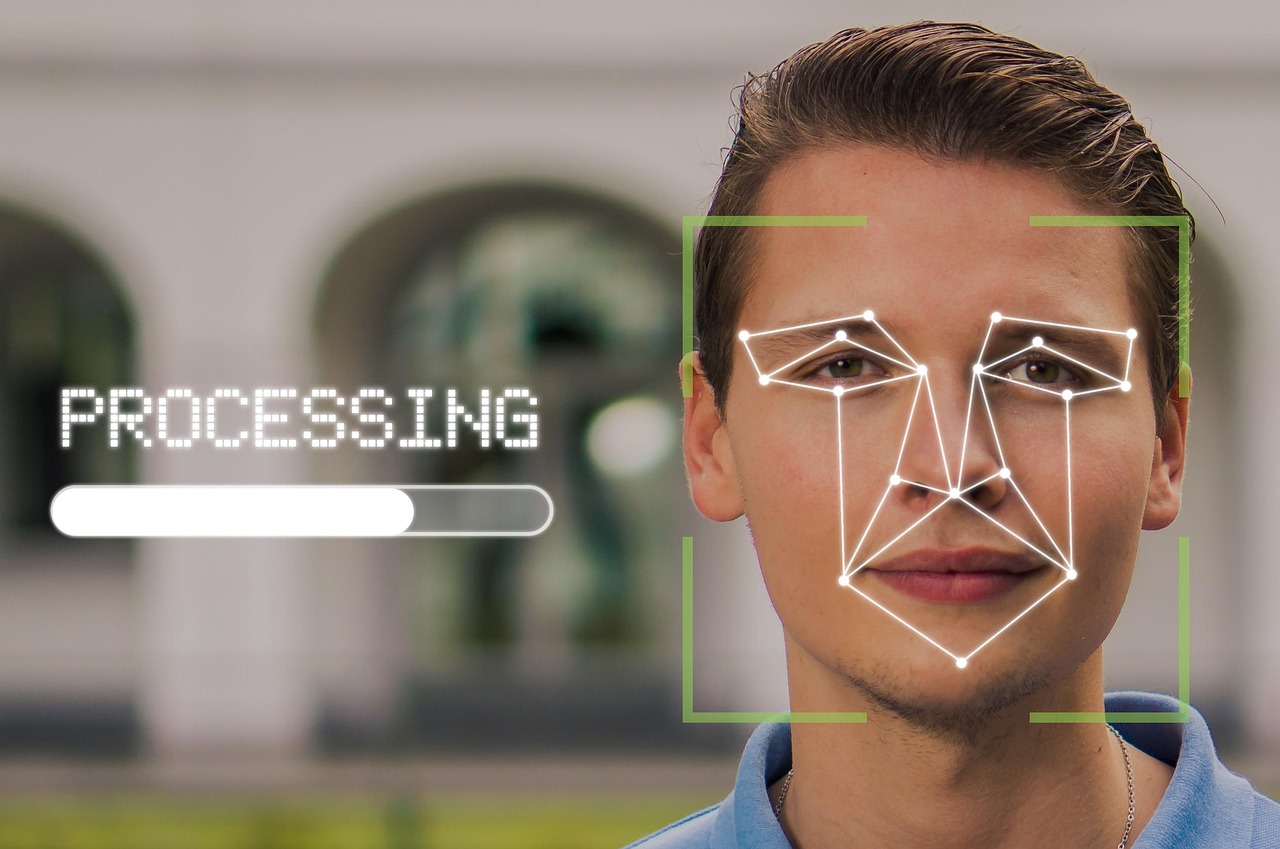

La montée en puissance des deepfakes audio constitue une avancée technologique fascinante, mais aussi un défi majeur pour la sécurité numérique. Ces voix synthétiques générées par intelligence artificielle reproduisent avec une précision troublante les intonations, le timbre et les expressions caractéristiques d’une personne. En 2025, alors que les systèmes de reconnaissance vocale s’invitent de plus en plus dans notre quotidien – de l’authentification vocale bancaire aux assistants personnels – la question se pose avec acuité : ces technologies sont-elles exposées aux manipulations via des deepfakes audio ? Le défi est de taille, car la capacité de la technologie audio actuelle à imiter fidèlement une voix humaine met en péril la fiabilité des systèmes de contrôle d’accès basés sur la biométrie vocale.

Les deepfakes ne sont pas simplement un outil de divertissement ou une curiosité technologique ; ils sont devenus un vecteur de manipulation média puissant, capable de nuire à la crédibilité des institutions, de compromettre des données sensibles et même d’orchestrer des fraudes complexes. Pour les experts en cybersécurité, comprendre les mécanismes derrière ces imitations vocales et adapter les protocoles d’authentification est devenu une priorité. Pourtant, détecter l’usage frauduleux de voix synthétiques reste un combat technique difficile, qui nécessite la mise en œuvre combinée de l’analyse audio, de l’apprentissage automatique et d’une vigilance accrue sur les sources d’information.

Paradoxalement, si les deepfakes audio peuvent induire en erreur les outils automatisés de reconnaissance, ils dévoilent aussi certaines failles perceptibles par une inspection attentive, notamment à travers l’examen des anomalies de tonalité ou du contexte d’utilisation. Ce phénomène illustre l’importance d’associer technologies avancées et formation humaine pour repousser les limites de la fraude vocale. Cette exploration détaillée aide à mieux saisir les risques, les techniques de détection et les mesures de prévention essentielles dans un monde où la voix devient une clé d’accès stratégique à nos identités numériques.

Fonctionnement des deepfakes audio et vulnérabilités des systèmes de reconnaissance vocale

L’avancée des techniques de deepfakeAudio repose sur des modèles d’intelligence artificielle de plus en plus sophistiqués, capables de reproduire le timbre, le rythme et les inflexions d’une voix humaine à partir d’un simple court extrait audio. Ces systèmes exploitent des réseaux neuronaux profonds et des architectures telles que les GANs (Generative Adversarial Networks) ou les modèles VITS, qui génèrent des voix synthétiques d’une qualité quasi indiscernable de la réalité.

La reconnaissance vocale, utilisée comme mécanisme d’authentification vocale, repose souvent sur l’analyse de caractéristiques acoustiques uniques du locuteur, telles que la fréquence fondamentale, les formants et la dynamique prosodique. Or, les deepfakes peuvent reproduire ces caractéristiques avec un réalisme impressionnant, rendant la distinction entre voix authentique et voix synthétique particulièrement ardue.

Plusieurs vulnérabilités apparaissent dans ce contexte :

- Extraction de voix à partir de courts extraits : Dès trois secondes d’audio, l’IA peut apprendre à modéliser une voix, permettant à des acteurs malveillants de créer un clone vocal à partir d’enregistrements publics ou piratés.

- Contournement des systèmes biométriques : La capacité des systèmes deepfakeAudio à imiter les signatures vocales permet souvent d’éviter les filtres de validation vocale traditionnels, notamment dans les banques ou services sensibles.

- Réponse en temps réel : Certains modèles permettent des générateurs de voix synthétiques en temps réel, rendant plus délicate la détection face à des échanges téléphoniques en direct.

À titre d’exemple, en 2024, une fraude audacieuse a été rapportée où un cybercriminel a réussi à duper un système bancaire en imitant la voix du directeur financier à l’aide d’une technologie deepfakeAudio, validant ainsi des transferts importants. Cette affaire illustre à quel point la sécurité numérique dépend désormais de mesures adaptatives.

| Aspect | Vulnérabilité liée aux deepfakes audio | Conséquence sur la reconnaissance vocale |

|---|---|---|

| Qualité du modèle IA | Voix synthétiques très réalistes, difficilement discernables | Risque élevé de fausse authentification |

| Durée de l’extrait | Moins de 10 secondes suffisent pour cloner une voix | Possibilité de clonage avec peu d’effort |

| Utilisation en temps réel | Génération de voix à la volée | Difficulté de détection pendant l’appel |

| Systèmes biométriques | Repose souvent sur des signatures vocales fixes | Contournement facilité |

La prise de conscience de ces vulnérabilités est essentielle afin de renforcer les systèmes actuels, notamment par le biais d’une meilleure authentification vocale combinée à des couches de sécurité supplémentaires.

Techniques avancées d’analyse audio pour détecter les deepfakes vocaux

Face à la sophistication croissante des voix synthétiques, la cybersécurité doit s’appuyer sur des méthodes innovantes d’analyse audio capables de distinguer les authentiques des voix synthétiques. Plusieurs techniques ont émergé pour renforcer la détection :

- Analyse spectrographique : Ce procédé permet d’examiner la structure fréquentielle du son. Les deepfakes audio peuvent présenter des anomalies dans les harmoniques ou des ruptures subtiles non naturelles.

- Évaluation des microvariations : Les voix réelles comportent des variations fines dans la respiration, les pauses, ou les fluctuations de fréquence difficilement répliquées parfaitement par l’IA.

- Détection d’anomalies prosodiques : Les modèles de synthèse vocal tendent à générer des intonations régulières et monotones, ce qui peut servir de signature discrète pour identifier les deepfakes.

- Reconnaissance des artefacts numériques : Certains traitements de post-production laissent des traces perceptibles uniquement par des algorithmes.

Lorsqu’elle est combinée à des technologies de machine learning, cette analyse fine devient un rempart essentiel. En entraînant des modèles sur de vastes bases de données comportant voix naturelles et deepfakes, il est possible d’extraire des critères discriminatifs précis. À ce titre, les réseaux neuronaux convolutifs (CNN) et les systèmes hybrides audio-visuels occupent une place importante.

Les progrès en détection automatique se traduisent également sur le terrain, où plusieurs logiciels spécialisés sont désormais intégrés dans les systèmes d’authentification vocale. Ces outils peuvent générer un score de confiance basé sur la qualité de la voix et son origine probable. Le recours au cross-référencement entre la voix et d’autres facteurs biométriques (empreinte digitale, reconnaissance faciale) accroît aussi l’efficacité.

| Techniques d’analyse | Indicateurs de deepfake | Avantages | Limites |

|---|---|---|---|

| Analyse spectrographique | Anomalies harmoniques, bruit de fond incohérent | Non-invasif, rapide | Peu efficace sur deepfakes très avancés |

| Microvariations vocales | Absence de respiration naturelle ou pauses | Finesse de détection | Demande souvent un enregistrement de qualité |

| Prosodie et intonation | Modulations trop régulières | Permet détection sur courts extraits | Peut fausser avec voix monotones naturelles |

| Artefacts numériques | Signatures des traitements IA | Détection automatique possible | Peut être contourné par post-processing |

La complexité de cette lutte souligne l’importance d’investir dans la recherche et d’actualiser continuellement les bases de données pour tenir compte des nouvelles générations de deepfakes audio.

Impact des deepfakes audio sur la sécurité des systèmes biométriques et stratégies d’atténuation

La fiabilité des systèmes biométriques basés sur la reconnaissance vocale est mise à rude épreuve par l’essor des deepfakes. Leur capacité à usurper une voix authentique soulève des questions cruciales en matière de sécurité numérique et de confiance dans ces outils.

Parmi les secteurs les plus concernés, les services bancaires représentent une cible privilégiée. Ces services utilisent fréquemment l’authentification vocale comme couche d’accès supplémentaire, mais cette méthode devient vulnérable face à la perfection croissante des voix synthétiques. La fraude exploitant cette faille peut entraîner des pertes financières importantes et gravement compromettre la confidentialité des données client.

Pour atténuer ces risques, plusieurs stratégies peuvent être mises en œuvre :

- Multi-facteurs : Combiner la reconnaissance vocale avec des méthodes complémentaires comme la reconnaissance faciale ou l’empreinte digitale pour renforcer la sécurité numérique.

- Analyse contextuelle : Intégrer des vérifications du contexte de la conversation, comme la géolocalisation ou le comportement en temps réel, afin de détecter les anomalies.

- Développement d’algorithmes anti-deepfake : Déployer des solutions basée sur l’analyse audio sophistiquée, utilisant par exemple l’IA pour reconnaître la signature digitale du vrai locuteur.

- Surveillance et mise à jour continue : Faire évoluer régulièrement les bases de données vocales et les protocoles de sécurité pour rester à jour face aux nouvelles technologies deepfakeAudio.

Un exemple concret est celui d’une importante institution financière qui a adopté une approche combinée en 2024, en intégrant un système d’authentification vocale avec détection d’anomalies audio et un processus manuel de vérification renforcé. Cette méthode a permis de réduire les cas de fraude de 70% en une année.

| Stratégies | Description | Bénéfices | Limites |

|---|---|---|---|

| Authentification multi-facteurs | Voix + biométrie supplémentaire | Renforce la fiabilité | Coût et complexité accrus |

| Analyse contextuelle | Contrôle du contexte et comportement | Détecte anomalies comportementales | Peut générer des faux positifs |

| Algorithmes anti-deepfake | Logiciels spécialisés de détection | Améliore détection automatisée | Développement continu nécessaire |

| Mises à jour régulières | Actualisation bases de données vocales | Adaptation aux nouvelles menaces | Nécessite ressources dédiées |

Ces mesures stratégiques soulignent l’importance d’une approche globale et adaptative en cybersécurité. D’ailleurs, le recours à des systèmes plus sophistiqués à base d’intelligence artificielle reste indispensable pour contrer la progression des deepfakes audio dans le domaine de l’authentification vocale.

Initiatives et outils pour renforcer la sécurité face aux deepfakes audio en 2025

La lutte contre les deepfakes audio ne dépend pas uniquement de la technologie. En 2025, une synergie s’organise entre acteurs publics, entreprises technologiques et experts en cybersécurité pour proposer des outils et des cadres réglementaires adaptés.

Parmi les initiatives majeures, on peut souligner :

- Déploiement de plateformes collaboratives : Certaines plateformes agrègent les données audio suspectes et partagent les modèles de deepfakeAudio détectés à travers un réseau sécurisé pour accélérer la réaction collective.

- Promotion de la sensibilisation : Des campagnes éducatives sont lancées pour informer le public sur les risques liés à la manipulation média et la nécessité d’une vigilance accrue autour des données vocales personnelles.

- Développement de standards biométriques renforcés : Avec une volonté d’harmoniser les protocoles d’authentification vocale à l’échelle mondiale, des normes plus strictes sont proposées pour mieux protéger l’identité des individus.

- Renforcement de la législation : De nouvelles lois encadrent désormais la création, la diffusion et la sanction des deepfakes malveillants, incluant des peines plus sévères pour les fraudes impliquant la duplicité vocale.

Le secteur bancaire, la justice et même les médias s’impliquent activement dans cette dynamique. Par exemple, plusieurs banques ont intégré en 2025 un protocole de double vérification vocale croisé avec un code secret vocalé pour limiter la fraude.

| Initiative | Description | Impact attendu | Acteurs concernés |

|---|---|---|---|

| Plateformes collaboratives | Partage sécurisés des données de deepfakeAudio | Améliore détection collective | Entreprises, chercheurs |

| Sensibilisation publique | Campagnes informatives et pédagogiques | Réduit les risques d’hameçonnage vocal | Grand public, écoles |

| Normes biométriques | Standardisation des protocoles de reconnaissance vocale | Renforce sécurité globale | Industrie, régulateurs |

| Législation | Lois sur la création et l’usage des deepfakes | Discipline le marché noir | Politiques, forces de l’ordre |

Les ressources liées à la sécurité numérique et la protection des données vocales sont désormais priorisées, notamment par des organismes spécialisés. Pour en savoir plus sur les meilleures pratiques en biométrie et sécurité, la ressource suivante offre un éclairage pertinent : biométrie plus sécurisée que les mots de passe.

Formation indispensable en cybersécurité : clé de voûte contre la menace des deepfakes audio

Si la technologie progresse, la composante humaine demeure essentielle dans la lutte contre les manipulations média liées aux deepfakes audio. La formation en cybersécurité joue un rôle déterminant pour habiliter les professionnels et le grand public à mieux comprendre et combattre ces menaces.

Les centres comme CyberInstitut proposent désormais des cursus spécialisés qui abordent :

- Les principes et mécanismes techniques des deepfakes et de la technologie audio.

- Les méthodes avancées de détection et d’analyse audio.

- Les stratégies de prévention et d’authentification vocale renforcée.

- La gestion des incidents de sécurité liés aux deepfakes et la communication de crise.

La sensibilisation croissante aux enjeux pousse également les entreprises à former leurs collaborateurs à reconnaître les tentatives de fraude vocale, notamment au travers de scénarios d’ingénierie sociale où des deepfakes audio sont utilisés pour le phishing ou l’usurpation d’identité.

| Thèmes de formation | Objectifs pédagogiques | Bénéfices pour l’entreprise |

|---|---|---|

| Connaissance des deepfakes audio | Comprendre le fonctionnement et risques | Meilleure identification des menaces |

| Techniques de détection | Maîtriser les outils d’analyse audio | Réduction des risques de fraude |

| Stratégies de prévention | Mise en œuvre de procédures sûres | Renforcement de la sécurité globale |

| Gestion des incidents | Réagir efficacement en cas d’attaque | Limitation des dégâts potentiels |

Cette montée en compétence s’accompagne d’une nécessaire culture numérique où la vigilance devient un réflexe quotidien. Pour approfondir cet aspect, il est recommandé de consulter le guide complet sur la biométrie disponible ici : biométrie plus sécurisée que les mots de passe.

Dans un univers où la voix synthétique peut servir à la fraude ou à la désinformation, il est crucial de conjuguer efforts technologiques et formation humaine pour préserver la confiance dans les systèmes de reconnaissance vocale et assurer une meilleure sécurité numérique collective.

Questions fréquentes sur les deepfakes audio et la reconnaissance vocale

- Qu’est-ce qu’un deepfake audio ?

Un deepfake audio est un enregistrement sonore manipulé par intelligence artificielle afin de reproduire une voix humaine avec une grande précision, rendant difficile la distinction entre la voix vraie et la voix synthétique. - Les systèmes de reconnaissance vocale peuvent-ils être trompés par ces voix synthétiques ?

Oui, les deepfakes audio sont capables de contourner certains systèmes d’authentification vocale traditionnels en imitant fidèlement les caractéristiques biométriques de la voix. - Comment peut-on détecter un deepfake audio ?

On peut détecter ces manipulations via l’analyse spectrographique, l’évaluation des microvariations vocales, la détection des anomalies prosodiques, et grâce à des algorithmes d’intelligence artificielle spécialisés. - Quelles mesures de sécurité renforcer pour se protéger ?

Il est recommandé d’adopter des systèmes multi-facteurs, d’améliorer l’analyse contextuelle, d’utiliser des algorithmes anti-deepfake, et de mettre à jour régulièrement les bases de données vocales. - Pourquoi la formation en cybersécurité est-elle importante face aux deepfakes ?

Parce qu’elle permet aux professionnels et au grand public de comprendre les risques, de maîtriser les outils de détection, et d’adopter des comportements sûrs pour limiter les impacts des deepfakes audio sur la sécurité numérique.